Was genau ist ControlNet und warum sind die Nutzer von Stable Diffusion so begeistert davon?

Stell dir die img2img-Funktion von Stable Diffusion auf Steroiden vor.

Bei der normalen img2img-Funktion hattest du keine Kontrolle darüber, welche Teile des Originalbildes du behalten und welche du ignorieren wolltest.

Mit ControlNet kannst du wählen genau welche Teile des Originalbildes beibehalten und welche ignoriert werden sollen (praktische Anwendungen sind im Moment die Kontrolle Posen und Kompositionenaber mit der Zeit werden wir viele weitere Modelle und Anwendungsfälle sehen).

Mehr darüber kannst du auf der offiziellen Github-Repositorium und die wissenschaftliche Arbeit.

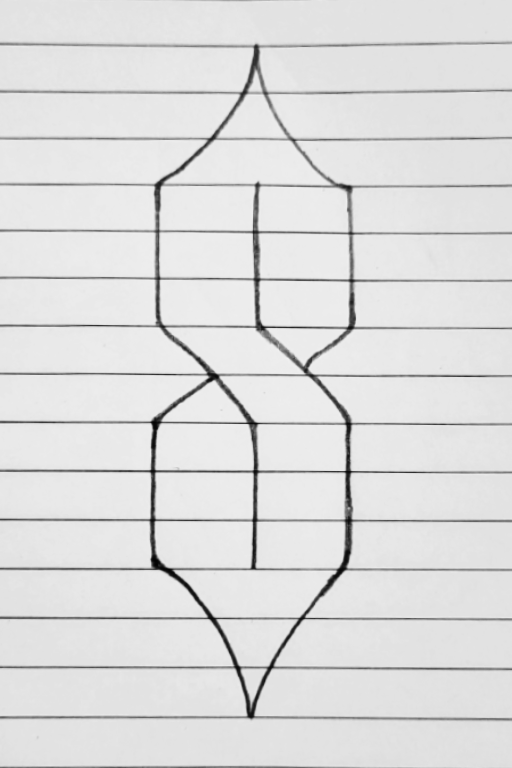

Was ist mit ControlNet möglich? Du kannst jede Pose kopieren:

Diffusionsmodell: RPG von Anashel

ControlNet Modell: control_openpose-fp16 (OpenPose)

Du kannst Umgebungen verändern und dabei die Kernmerkmale des Ortes beibehalten:

Diffusionsmodell: Privat (aber ähnlich wie Vorsätzliche)

ControlNet Modell: control_depth-fp16 (Tiefe)

Du kannst die Kritzeleien eines Kindes (oder deine eigenen) in Meisterwerke verwandeln:

Und natürlich kannst du auch so einen Blödsinn machen:

Diffusionsmodell: RealisticVision

ControlNet Modell: control_scribble-fp16 (Scribble)

ControlNet erreicht dies durch die Extraktion eines verarbeiteten Bild aus einem Bild, das du ihm gibst.

Das verarbeitete Bild wird verwendet, um zu kontrollieren. den Diffusionsprozess, wenn du img2img (das ein anderes Bild zum Starten verwendet) oder txt2img verwendest, und steuere ihn in Richtung des gewünschten Ergebnisses.

ControlNet ist ein wichtiger Meilenstein auf dem Weg zur Entwicklung hochgradig konfigurierbarer KI-Tools für Kreativeanstelle der „Soufflieren und Beten“-Stabilen Diffusion, die wir heute kennen.

Wie kannst du also beginnen, die kontrollieren? deine Bildgenerationen?

Lass uns loslegen.

1. ControlNet Modelle herunterladen

Lade zuerst die ControlNet-Modelle herunter, damit du die anderen Schritte durchführen kannst, während die Modelle heruntergeladen werden.

Denke daran, dass diese Modelle getrennt von deinem Diffusionsmodell verwendet werden. Idealerweise hast du bereits ein Diffusionsmodell für die Verwendung mit den ControlNet-Modellen vorbereitet.

Wenn du noch keins hast, empfehle ich ein beliebtes Modell wie Deliberate (allgemeiner Zweck) oder Realistische Vision (hyperrealistische Menschen).

Gehe zu diesem Link:

https://huggingface.co/webui/ControlNet-modules-safetensors/tree/main

Du kannst bestimmte Modelle auswählen oder sie alle herunterladen (du lädst die .safetensor Dateien).

Ich empfehle, sie alle zu kaufen, da sie nur 700 MB~ pro Stück groß sind. Es kann sein, dass du 5,5-GB-Versionen im Umlauf siehst, aber das sind ältere Versionen und nicht mehr notwendig.

Wenn du dir nicht sicher bist, was du willst, fang mit der Tiefe und openpose Modelle.

Du kannst alle Modelle online ausprobieren, bevor du sie herunterlädst: https://huggingface.co/spaces/hysts/ControlNet

2. WebUI herunterladen

Ich gehe davon aus, dass du die Stable Diffusion WebUI von AUTOMATIC1111 bereits heruntergeladen hast. Wenn nicht, folge den Installationsanweisungen für deine Plattform und komm zurück zu diesem Artikel, wenn du fertig bist.

- Installation für Windows (NVIDIA GPU): Anleitung

- Installation für Windows (AMD-GPU): Anleitung

- Installation für Apple Silicon (Mac M1/M2): Anleitung

- Installation für Linux: instructions

3. ControlNet-Erweiterung herunterladen

Deine WebUI sollte jetzt laufen. Zur Erinnerung:

- Windows: Doppelklick auf

webui-user.bat(Windows Batch File), um zu starten - Mac: Führe den Befehl aus

./webui.shim Terminal aus, um zu starten - Linux: Führe den Befehl

webui-user.shum zu starten

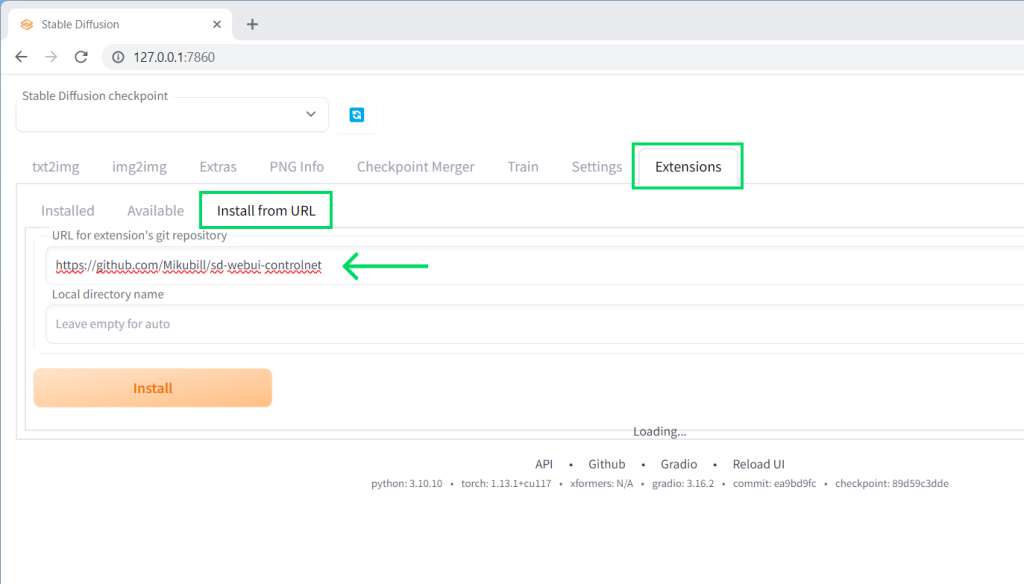

Klicken Sie auf das Extensions Registerkarte und die Install from URL Unterregisterkarte:

Kopiere den folgenden Link und füge ihn in das Feld mit der Bezeichnung ein: URL for extension's git repositoryund drücke dann die große Install Taste.

https://github.com/Mikubill/sd-webui-controlnet

Wenn die Installation abgeschlossen ist, erhältst du eine Bestätigungsmeldung.

Schließe deine WebUI (schließe die Eingabeaufforderung/das Terminal oder drücke Strg+C) und starte sie erneut.

4. Platziere das/die Modell(e) im WebUI-Ordner

Platziere die .safetensor Modell/e, die du heruntergeladen hast, innerhalb von stable-diffusion-webuiextensionssd-webui-controlnetmodels.

Hinweis: Dies ist ein anderer Ordner als der, in dem du deine Diffusionsmodelle abgelegt hast!

5. ControlNet zur Steuerung des Netzes verwenden

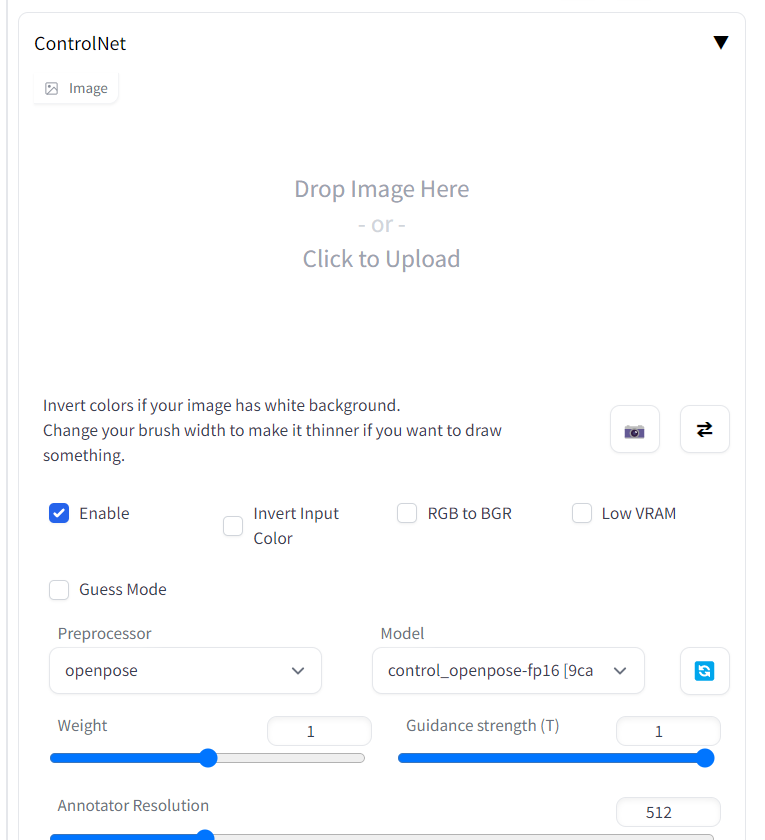

Hinweis: ControlNet hat keine eigene Registerkarte in AUTOMATIC1111. Stattdessen wird es als eigener Abschnitt am Ende der Registerkarten txt2img oder img2img angezeigt.

Scrolle nach unten und erweitere diesen Abschnitt entweder auf der Registerkarte txt2img oder auf der Registerkarte img2img.

To-dos:

- Überprüfen „

Enable„ - Wähle einen Präprozessor und dann das entsprechende Modell aus (z. B.

openpose&control_openposer-fp16)

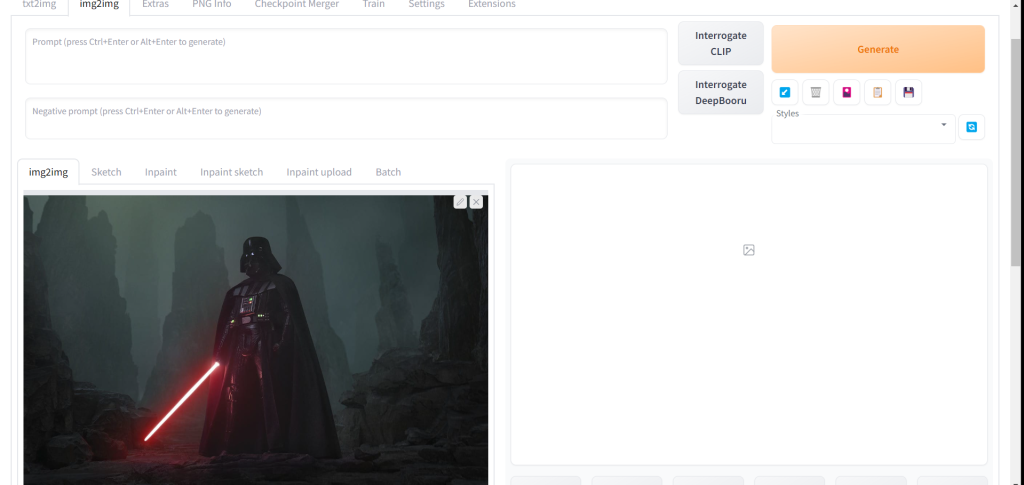

img2img

Das Gleiche wie immer. Ziehe das Bild, das du verwenden willst, in den normalen img2img-Eingabebereich.

Hier werde ich ein Bild von Darth Vader verwenden:

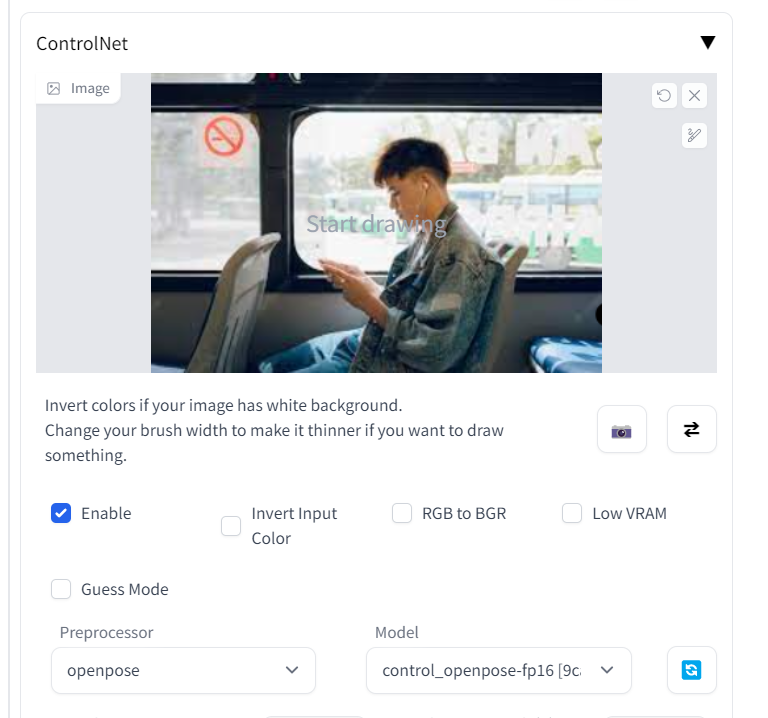

Dann scrollst du nach unten zum Abschnitt ControlNet. Ziehe und lege dein Controller-Bild in den ControlNet-Bildeingabebereich ein.

Das Bild des Controllers ist das, was du zur Steuerung des Ergebnisses verwenden wirst. Was du für dieses Bild verwendest, hängt davon ab, welches Modell du verwendest.

Wenn du zum Beispiel das OpenPose-Modell verwendest, enthält das Controller-Bild die Pose, die du haben willst.

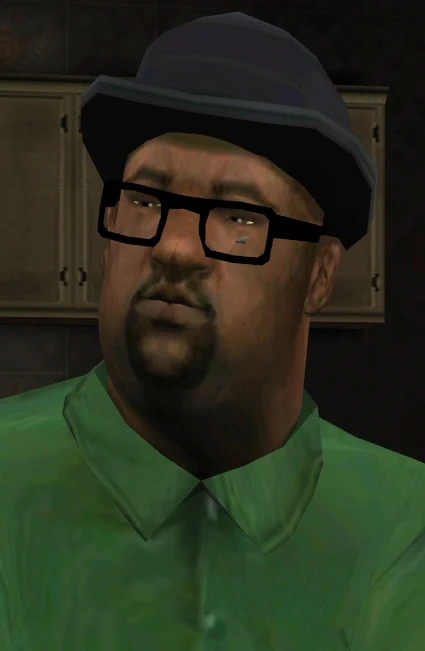

Als Beispiel verwende ich dieses Bild eines Mannes in einem Bus:

Du wirst die ursprünglichen Pixel dieses Controller-Bildes im endgültigen Bild nicht wiederfinden.

Das Einzige, was zählt, ist, welche Informationen das von dir gewählte ControlNet-Modell aus diesem Bild verarbeitet (scrolle nach unten und klicke Preview annotation result um zu sehen, welche Informationen das ControlNet-Modell aus dem Bild des Controllers extrapoliert).

Vergiss nicht, einen Prompt zu schreiben! Ich nehme ein paar thematische und stilistische Elemente aus meinem Originalbild, verwende das ControlNet-Bild, um die Pose zu steuern, und verwende schließlich den Prompt, um die Dinge zu verdeutlichen:

darth vader sitting on bus looking at his phone wearing black gloves, new york city passing by outsideDrücke auf Erzeugen:

Rechts: img2img Eingabebild (stilistische Inspiration)

Vergiss nicht, dass OpenPose eines von vielen Modellen ist, von denen jedes unterschiedliche Möglichkeiten und Anwendungen hat. Ich empfehle dir, alle Modelle herunterzuladen und selbst zu testen!

Hinweis: Du kannst auch dein eigenes Skelett und deine eigenen Karten verwenden, und das jeweilige Modell wird sie erkennen. Das kann dir helfen, die genaue Pose zu finden, die du willst, ohne sie erst aus einem Bild zu extrahieren. Vergiss nicht, deinen Präprozessor auf None zu setzen, wenn du sie verwendest, sonst werden sie wieder verarbeitet. Mehr dazu weiter unten.

Es scheint, als würde das ControlNet-Eingangsbild nicht funktionieren?

Du solltest das Kontrollkästchen „Aktiviert“ im ControlNet-Bedienfeld aktivieren.

Vergewissere dich, dass du einen Prozessor und ein Modell ausgewählt hast.

Vergewissere dich, dass deine ControlNet-Erweiterung auf dem neuesten Stand ist. Gehe zu Extensions > Check for Updates. Aktualisiere deine Erweiterung, falls nötig, und starte die WebUI neu.

0 Kommentare